从价值对齐的信任意涵与信任样态来看,技术发展对人类提出了更高的要求。其要求作为类存在的人在价值对齐的进程中,必须厘清合作、信任与价值对齐这三者之间的逻辑关系与道德意涵,深刻反思人作为价值性存在的根基何在,充分审视技术信任的顶层逻辑及权重,高度重视信任的反面,警惕价值对齐的非道德现象与异化,积极守护技术语境中的人际信任,避免信任的单向度。因此,应以基于道德的信任校准价值对齐,将人类作为人机 (技) 信任链构建的出发点和落脚点,才能规避价值对齐的陷阱,走向有效的价值对齐,进而确保人工智能安全。

添加微信好友, 获取更多信息

复制微信号

人类的生物性缺陷与技术日趋拟人化、智能化使得人机 (技) 融合成为了人类未来的一种新样态。就人机(技)融合而言,技术所体现的价值观与人类价值观相一致即价值对齐,是其所必须面对的一个重要问题。当下关于价值对齐的内涵、标准、基准、效应等问题的争议在凸显人机(技)融合进程中的人类逻辑与技术逻辑之间,智能系统内部各个智能体之间融合的必要性、重要性与不确定性的同时,更是指向了价值对齐基准的模糊性与多元化。反观上述问题,主要表现为两个方面:一方面为若二者之间出现偏差甚或背离,将违背技术向善的宗旨,并诱发巨大的风险;另一方面为未经审视的价值对齐,特别是仅仅为了对齐的价值对齐甚或盲目的价值对齐不仅会带来价值对齐的陷阱与异化,更会导致人类的异化乃至人类文明的脆断。若人机(技)融合是人类未来的一个必选项,那么,价值对齐则可能是导引人机(技)融合走向的指南针。

目前,以非道德的方式所进行的欺骗性对齐、伪对齐等现象已经出现,这使得价值对齐本身面临更多质疑。特别是因数智技术的生成性、涌现性、交互性、适应性、拟主体性等特性所带来的价值对齐过程中的越狱、幻觉等问题,使得信任被视为了“安全的致命弱点”。(埃文·吉尔曼、道格·巴斯,2019,译者序第1 页) 因此,基于信任视角解析价值对齐,既是对价值对齐逻辑的厘清,更是对人类未来这个宏大问题的哲学审视。

一、价值对齐的信任意涵

从广义来看,价值对齐源自人类期冀自身价值观被技术理解并被实现,进而契合技术为人类带来福祉的诉求,是通向技术社会化与社会技术化双向奔赴的一种尝试。但与此同时,价值对齐所蕴含的巨大风险也备受关注,而信任则是应对风险的一种有效方式。从狭义来看,价值对齐包含技术和非技术两个维度,涉及人与人之间、人与技术之间、技术系统内部的各个智能体之间三个层级的对齐。其中,前者聚焦技术自身的可信度,后者聚焦对价值对齐的必要性、可能性、可行性及其局限性等的哲学社会科学研究。恰如布莱恩·克里斯汀(Brian Christian) 在关于对齐问题的研究中所言:“机器学习表面是技术问题,但越来越多地涉及人类问题。”(布莱恩·克里斯汀, 2023,导言第11 页) 因此,价值对齐最终的指向是人类,更精确地说是人类对自身能力的信任。

(一) 价值对齐的两个维度及其信任意涵

当人类期望技术能够以自己意欲的方式行事时,人类价值观的技术化成为了技术发展的一种必然态势。特别是伴随通用人工智能的发展,人类智能、人工智能与超级智能的多重交汇,人类价值观逐渐以编码的形式被技术化。近年来,信任被视为人机融合、人工智能技术研发的一个重要议题,诸如“可信任人工智能 (Trustworthy AI) ”“受信任的智能 (Trusted Intelligence) ”“信任设计(Trust by design)”等均在以将信任技术化的方式进行呈现。

在人工智能与人类价值对齐的进程中,其核心要义是对人类价值观的正确理解与导引,人工智能系统能够以合乎伦理的方式稳健地将其有效执行,并确保技术的可信、安全与可控。因此,价值对齐一方面是人类价值观融入人工智能系统之中;另一方面是人工智能系统还应自主推导出与人类价值观相符合的行动,即超级对齐。但无论上述哪个方面,都面临着人工智能“系统如何在不夸大其能力范围的情况下呈现有限的规范能力?具有规则识别能力的系统如何防止交互主体对规则性的操纵变成对其的信任”(Arnold T. & Scheutz M.,2023) 等等人类该如何信任技术的诸多问题。

就目前的技术研发来看,通过对人的意识、人类社会运作模式等的模拟、推断来提升技术可信度的方式是实现价值对齐的重要途径。诸如, 基于人类反馈的强化学习 (Reinforcenment Learning from Human Feedback,RLHF),即通过模拟人类社会的社交活动与模仿人类获得价值反馈的方式,来提升大语言模型与现有社会价值观对齐精准性;(Ruibo L. et al.,2023) 通过基于心智理论和反事实解释的融合来提升人类对图像识别系统模型信任的 CX-ToM (Counterfactual explanations with theory-of-mind)(Arjun R. Akula,2022) 等方法偏重模拟;基于“与其煞费苦心地尝试手工编码我们关心的东西,不如开发直接观察人类行为并从中推断我们的价值观和意图的机器” (布莱恩· 克里斯汀, 2023, 第 187 页)所展开的逆强化学习 (Inverse Reinforcement Learning,IRL),以及在此基础上迪伦·哈德菲尔德-梅内埃尔 (Dylan Hadfield-Menell) 等所提出的合作逆强化学习 (Cooperative Inverse Reinforcement Learning, CIRL) (Hadfield-Menell D.,2016) 等方法则偏重推断。然而,无论是上述哪种价值对齐的技术方法,都是在以基于人的视角而探寻技术与人之间的有效融通点,并以彼此可信的方式达到人机融合的最佳状态。

在某种意义上,人类发展史就是一部技术演化史。回顾人类历史,技术所产生的巨大影响使其成为了划分时代的一种标尺。如旧石器时代、新石器时代、青铜器时代、蒸汽机时代、信息时代、智能时代等,由技术变革驱动所形成的文明形态已经成为人类文明界定的一个依据。如农业文明、工业文明、信息文明、数字文明等。从技术哲学的视角来看,伴随技术对人类的深度影响,基于技术仅仅作为工具的理论框架所展开的关于技术的反思已经遭遇到了理论与现实的双重质疑。与此同时,技术价值论则逐渐被认可,对技术本质的解析也逐渐走向了存在论、认识论与价值论三向融合的视角。易言之,价值对齐的技术维度即技术自身的可信度,并非仅仅在于其作为工具的鲁棒性,且若仅仅局限于此,必将陷入技术工具论的误区,出现人被技术逻辑支配或者人被技术规制的价值对齐,进而背离了价值对齐的初衷。恰如兰登·温纳 (Langdon Winner) 在自主性技术与政治的关联研究中所揭示的:“我们在多大程度上应用‘工具—使用’与‘目的—手段’的观念,我们的经历就将在多大程度上与我们的预想不一致。”(兰登·温纳,2014,第 214 页) 因此,价值对齐中的技术可信度虽然是信任在技术层面的一种呈现,但这种呈现恰恰源自非技术的维度,即人类对信任的认知。

(二) 价值对齐的三个层级及其信任意涵

依据以人为出发点的原则,价值对齐的三个层级依次为人自身、人与技术之间、技术系统内部之间。在价值对齐的进程中,技术对人类意图的有效理解与推断是其获得人类信任的必要条件,而技术的可信度则是构建人类对其信任的重要判据。埃文·胡宾格 (Evan Hubinger) 将内部对齐( Inner alignment)、外部对齐(Outer alignment)、欺骗性对齐 (Deceptive alignment) 等视为构建人类对机器学习系统的安全性充满信心的有效方式。( Hubinger E.,2021) 从技术的视角来看,上述几种对齐方式,可以简化为内部对齐和外部对齐。其中,外部对齐指向设计者的意愿与用于构建人工智能系统的实际任务规范 (例如目标和奖励) 之间的一致性,内部对齐则指向任务规范和人工智能系统行为所反映的规范之间的一致性。(Jiaming Ji et al.,2023) 简言之,内部对齐重在实现所给定的目标函数,外部对齐则重在完成人类价值观或者预期目标的制定与转化。

从表面上看,与这种分类直接相关的是两个层级的价值对齐,即人与技术之间、技术系统内部之间。然而,更需要注意的是,就内部对齐和外部对齐而言,还存在一个更基础性的问题,即该如何确定目标函数。因此,人自身的价值对齐是极为重要且更为根本的一个层级。就人自身的价值对齐而言,价值观的多样性、偏主观性、情境性、时代性等使得价值对齐的基准线面临强劲的质疑。若所需对齐的价值观极其不确定,那么,对齐本身的前置条件就存在争议。面临这样的情形,价值对齐该如何展开呢?

事实上, “正当行为规则衍生的正确且合适的基础”(Luhmann N.,2017,p.5) 在于信任。信任是应对复杂性、风险性或曰不确定性的一种策略,信任的缺席将带来人类社会的失序。从技术发展的视角来看,技术在某种意义上就是一个不断消除风险并力求确定性的过程;从人类社会得以存续与发展的视角来看,信任之所以变成了一种必需品并非是“因为一切都是完全可预测的,或者完全可保证的,恰恰相反,即使在没有保证的情况下,人生也不得不继续前进”。(昂诺娜·奥妮尔,2017,第27 页) 因此,基于技术在人类社会中的生存论意蕴,对人自身的价值对齐问题破解虽然需要信任的出场,但这种出场并不意味着信任是万能的,更不能走向人对自身能力的盲目自信,而是对信任提出了更高的要求。这要求作为类存在的人在价值对齐的进程中,必须深刻反思人作为价值性存在的根基何在,充分审视技术信任的顶层逻辑及权重,并积极守护技术语境中的人与人之间的信任。

(三) 价值对齐的两个维度与三个层级的逻辑关系及信任表征

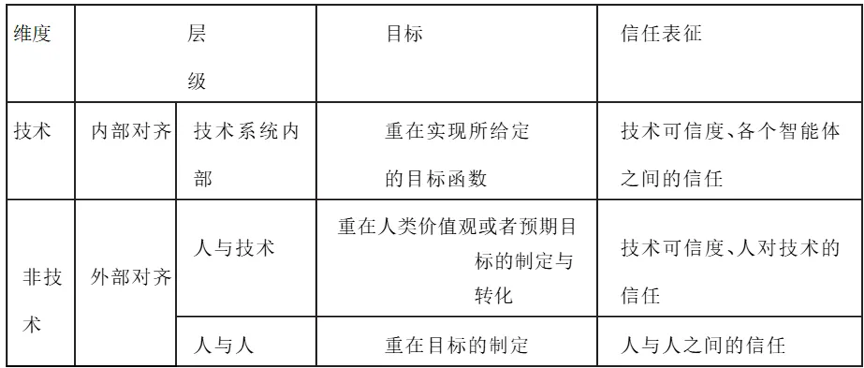

就价值对齐而言,从技术实现的路径来看,如表1 所示,技术系统内部的对齐可被归为内部对齐,技术自身的鲁棒性是其获取人类信任的关键因素;人与技术之间的对齐、人与人之间的对齐可被归为外部对齐。在人与技术之间的对齐中,人类对技术的信任包含技术的鲁棒性,但却不囿于此。事实上,从更本源的意义上来看,价值对齐的技术与非技术维度最终都必将指向人自身;与此同时,虽然人与人之间的价值对齐可被归为外部对齐,且会出现与技术的鲁棒性无关的人际信任现象,但是基于技术价值论的视角,其应是技术维度的基础,具有更深层的意义,并应被视为价值对齐的逻辑基础。

表1 价值对齐的维度、层级、目标与信任表征

控制论创始人诺伯特·维纳(Norbert Wiener) 在对第一次工业革命和第二次工业革命所带来的社会影响进行的探讨中,将人类的目标确立为“要建立一个以人类价值观而不是以买卖为基础的社会”(诺伯特·维纳,2022,第50 页),此刻人类价值观被视为既是导引技术发展的标尺,又是构成社会形态的核心。然而,随后,维纳面对新技术的发展便发出了“我在1947 年写下这些话时,我不得不说,这是一个非常渺茫的希望”(诺伯特·维纳,2022,第51 页) 的感叹。科学技术专家关于新技术的担忧因新技术力量之大与人类道德之恶的汇聚所表露出的这种无措令人不寒而栗,也正是这种无措恰恰提醒了人类应高度关注技术的风险。

同样在20 世纪中叶,汉娜·阿伦特 (Hannah Arendt) 面对行动所呈现出的不可逆性和不可预见性时,明确指出“对于不可预见性,对于未来不确定性的拯救,则包含在作出承诺和信守承诺的能力中”。(汉娜·阿伦特,2017,第184 页) 因此, 在人类的价值观与预期目标被技术化的进程中,伴随技术的日益智能化与日趋自主性的趋势,关于信任的研究也更为迫切,并呈现出了多学科融合的趋势。如IBM 所提出的“构筑对AI 的信任”、技术专家关于GPT 模型可信度评测等就汇集了技术、伦理学与社会学等的相关知识。

二、价值对齐的信任样态

从当下的技术发展来看,无论是无监督学习、监督学习,还是强化学习、逆强化学习与合作逆强化学习等,都是在多个智能体之间的循环交互中寻求目标的最优化,进而走向有效的价值对齐。也正是在智能体交互的过程中,由委托与授权而产生的信任问题也随之而至。在价值对齐的过程中,从目标完成的意义来看,基于为了完成某件事情或者某个任务而建立的信任主要表现为策略性信任、合作性信任、功能性信任、期望性信任、必要性信任以及强迫性信任等。其中,策略性信任 (Strategic Trust)反映的是我们对人们将怎样行动所持的期望,合作性信任、功能性信任则从偏实操的维度呈现人与人、人与技术之间的融合模式,期望性信任与必要性信任则更凸显了委托者与受托者之间的意愿,作为如果不信任就无法实现自己目标的强迫性信任则暗含了人类在技术面前的某种无力感。然而,更需要值得深思的是,若价值对齐是人机 (技) 融合的一条必经之路,那么,对上述信任样态的解码则是实现有效价值对齐所必须面对的问题。

(一) 人机 (技) 融合的信任链与价值对齐的信任基准

依据“不能建立信任,特别是最终用户的信任,惠及所有利益相关方的个人数据生态系统就将永远不会存在”(托马斯·哈乔诺等,2018,第139 页) 的逻辑,就现有的研究来看,基于贝叶斯网络的信任模型、人机协同双向价值对齐的计算框架 (Luyao Yuan et al.,2022) 等从技术视角的研究呈现了信任的技术化路径,关于技术的透明性、可解释性的多学科解析等则在以打开技术“黑箱”的方式力图消解用户对技术的陌生感、模糊性等,进而构筑人机 (技) 之间的信任链。

价值对齐作为人机 (技) 融合的一条技术路线,其可能形式有以人类为主机器为辅、机器为主人类为辅,以及以两方较为对等形式进行的双向合作。然而,无论以哪种形式,需要明晰的是,虽然价值对齐是通过技术所展开的人类诉求实现过程,但人类社会的特质恰恰在于人具有价值属性,而并非仅仅是人拥有技术。就人机 (技) 融合的信任链而言,其“产生的前提是人要自信(这种自信心也是匹配训练出来的),才能产生他信和信他机制”。(刘伟,2019,第213 页) 因此,虽然技术构成了人类生存的条件,但并不意味着人被技术框定,并且还要“避免误解:人的条件不等于人的本性,与人的条件相应的所有人类活动和能力的总和,都不构成任何类似于人的本性的东西”。(汉娜·阿伦特,2017,第3 页)

技术的活动并不能也不应成为人类本性的东西。当维纳以“不论我们把我们的决策委托给金属组成的机器抑是血肉组成的机器 (机关、大型实验室、军队和股份公司),除非我们问题提得正确,我们绝不会得到正确的答案”(诺伯特·维纳,2017,第166 页) 来描述人类未来时,事实上就已经以警示的口吻给出了人在技术化进程中应当为何的答案。同样地,面对价值对齐,关于技术霸权的忧惧与人类自我意欲实现的期冀二者之间的纠结将更为复杂。从技术路线来看,“可预测性和意图清晰性几乎是相对的:行为可预测是假定旁观者知道你的目标是什么;行为意图清晰则是假定他们不知道。”( 布莱恩·克里斯汀,2023,第201 页) 那么,人类该如何面对在价值对齐的进程中,所生成或涌现出的那种被技术推测或者被技术创造的自我呢?克里斯多夫•库克里克 (Christoph Kucklick) 关于数字化时代的微粒人解析极具启发性,“现代人的骄傲是能够成为某个人并且能够坚持做这个人。微粒人的骄傲在于一直成为另外一个人,同时不会失去自我。这是一个极其苛刻的态度”,(克里斯多夫·库克里克,2018,第196 页) 然而,这种极其苛刻的态度恰恰是人类所必须坚守的。若无此坚守,人类的生命将变成一场技术化的游戏。因此,虽然合作性信任与必要性信任可能是人机 (技) 融合的润滑剂,但人机 (技) 融合的信任链构建不是旨在将人类交付于技术,更不能走向用技术对齐技术的技术驱动性信任闭环,而是将人类作为信任链构建的出发点和落脚点。基于此,价值对齐不应是将人类推向由技术构造的强迫性信任,而是应以人之为人作为其信任的基准。

(二) 价值对齐的非道德现象与信任的道德性

为了完成人类规定的目标,技术以操作、欺骗等方式完成价值对齐的非道德现象已经出现。如,OpenAI 明确指出:“在某些领域,我们的系统可能会导致智能体采用欺骗评估者的策略。例如,一个本应抓取物品的机器人将其操纵器放置在相机和物体之间,使其看起来只是在抓取它。”(Amodei D. et al.,2017) 显而易见的是,这种现象一方面是人被机器的功能所欺骗,另一方面机器却又恰恰从完成目标的意义上提升了其技术“可信度”,增强了人类对其的“信任”。这种现象可被视为仅仅以完成目标为目的而忽略完成目的之手段正当性的“策略性”信任。

在当下,减少以及避免模型的自我欺骗、操纵行为,确保系统的可信与可控等是价值对齐亟待解决的难题。特别是在强化学习系统中,面对智能体是“奖励的奴隶;但是它们是拥有强大算力和不断试错的奴隶”( 布莱恩·克里斯汀,2023,第119 页) 的情形,技术的伦理属性成为了价值对齐不得不面对的一个重要问题。如,以价值对齐中的奖励为例,由于奖励系统设计的重结果轻过程缺陷,出现了奖励破解 (Reward Hacking)(Jiaming Ji et al.,2023)、奖励绕圈 (Cycle- Proofing Rewards)(布莱恩·克里斯汀,2023,第 119 页) 等价值对齐失常现象。从表面上看,智能体确实完成了给定的目标并获得了奖励,但其完成任务的方式却存在道德争议,并违背了价值对齐的初衷。因此,基于知识和经验为基础的策略性信任虽然在价值对齐的过程中完成了阶段性的目标 ,并以自身利益理性计算为核心建立起了工具意义上的信任,但这种信任因其存在的基础是不确定性,因而是极其脆弱的。特别是这种信任对道德维度的忽略使得其蕴藏了较高的风险,因此,“对于解决多种集体行动问题,对于创造一种环境,使人们能够在一起良好地运用自己的理性来说,道德主义信任才是关键。” (埃里克·尤斯拉纳,2006,第57 页)

然而,就信任的道德性而言,在罗素·哈丁 (Russell Hardin) 关于“信任作为道德”(Har‐ din R.,2002,p.74) 的谈论中,认为将信任本身视为一个道德问题是错误的,并且“如果我们普遍希望将信任概念道德化,那么,我们将不得不去掉那些基于信任来完成坏的目的的行为”,(Hardin R.,2002,p.75) 但这并非意味着对信任道德性的完全否定,恰恰说明信任无论是从目的来看,还是从行为来看,都应当是善的。

(三) 价值对齐的异化与信任的单向度

海德格尔关于“现代技术之本质是与现代形而上学之本质相同一的”(孙周兴,1996,第885页) 的判断,充分显示出技术作为完成了的形而上学已经进入到了生命、语言、政治等的规定之中。技术力量带来了沉思生活与积极生活等级秩序的倒转,沉思本身的意义被消解,世界异化已经悄然而至。“工业社会拥有种种把形而上学的东西改变为形而下的东西、把内在的东西改变为外在的东西、把思维的冒险改变为技术的冒险的手段”,(赫伯特•马尔库塞,2008,第185 页)那么,现代技术将一切工具化、齐一化、功能化、物化的特征在价值对齐的进程中是否存在呢?

事实上,当价值对齐意味着人类的价值观与技术的价值观在联盟的过程中走向融合并趋于一致时,从最低的层级上来看,这暗含着人类价值观可被技术化和技术具有了呈现人类价值观的潜能;从更高的层级来看,这种潜能将因数据智能的自我生成、自我参照、自我修改等自主性的日趋增长所形成的由技术对齐技术的技术闭环,而导致人类在技术回路中的被单一化与工具化,进而出现人类脱轨或曰被抽离的状态,并走向价值对齐的异化。这种异化并不是简单地指向对价值对齐初衷的背离,而是人类本身被异化乃至人作为整体性存在的消解。

暂不论人工智能末世论, 当下关于“辩论机制的收敛性”(Jiaming Ji. et al.,2023) 最终导致趋于单一回答的担忧就是在警示人类价值观被技术驱动的单一化趋势。“当共同世界只在一个立场上被观看, 只被允许从一个角度上显示自身时, 它的终结就来临了。”(汉娜· 阿伦特, 2017,第39 页) 基于此,当价值对齐变成了被技术理性逻辑所统治时,人类理性的终结和价值观的终结也将随之而至。这种特征是否会将信任推向以技术为基础的单向度模式呢? 若“技艺人的典型态度:他对世界的工具化,他对工具的信任,对人工制品制造者的生产力的信任” (汉娜·阿伦特,2017,第240 页) 等成为现代社会的主导观念,那么,技术或技术思维将成为信任形成与评判的重要元素,此时的信任也将逐渐走向由技术驱动的单向度。

三、合作、信任与价值对齐

价值对齐需要基于多方合作而展开,从功能方面来看,信任并非合作的前提条件,但其可以更有效地“简化复杂性”。(Luhmann N.,2017,p.9) 然而,虽然“合作常常需要信任,特别是相互信任。如果是完全不信任,那么,在自由行动者之间的合作则将失败。进一步说,如果信任仅仅是在单方面,那么,合作可能也是无效的;如果信任是盲目的,则将诱发欺骗”。( Gambetta D.,1988, p.219) 同样地,基于信任的合作将提升价值对齐的速度,但加速的目的不应是技术对人的操纵,若信任是单向的,则价值对齐是虚幻的;若信任是盲目的,则价值对齐是危险的。因此,需要充分审视合作、信任与价值对齐的关系。

(一) 合作、信任与价值对齐的边界

若信任仅仅基于暗合利益 (encapsulated interest),那么,道德并非是必选项,甚至可被忽略。然而,仅以利益驱动但以非道德的方式所形成的信任因其所带来的负面影响而一直备受诟病。就人工智能的发展而言,无论是负责任的人工智能、可信的人工智能,还是人工智能向善等,都已经将伦理道德作为一种规范性的要求纳入技术之中。在关于人机 (技) 融合的信任工程研究中,伦理道德被视为 “构建人类与人工智能之间建立适当的双向信任”(Ezer N. et al., 2019) 的一个重要的参数。那么,该如何看待在这种合作中所形成的信任呢?

苏珊娜· 托尔梅杰 (Suzanne Tolmeijer)、亚伯拉罕· 伯恩斯坦 (Abraham Bernstein) 等发现:在人工智能和人类专家合作所进行的伦理决策中,人类虽然在道德上具有较高的可信度,但其能力却不如人工智能。虽然人工智能的建议和决策比人类专家的建议和决策更容易被接受,但人类专家被赋予了更高的道德信任和责任。(Tolmeijer S. et al.,2022) 因此,在人工智能与人类价值观对齐的进程中,虽然完成给定的目标是走向价值对齐的必要环节,但关于欺骗性、伪对齐等现象的出现恰恰指向了合作中的能力与道德问题。毫无疑问,当价值对齐以人与技术形成联盟的方式来为人类谋求美好生活时,技术是助推人类走向美好生活的强劲动力,人类对技术能力的信任和对自身能力的信任则是形成上述联盟的理论基础,但基于这种信任的合作更需要人类确立上述联盟的边界。在人类与人工智能合作的过程中,出现了将人工智能视为合作伙伴而非仅仅是工具的趋势,并主张将人类和人工智能视为一个团队(Human-AI Teams) 的理念。

就价值对齐而言,从人类和人工智能作为一个团队的视角来看,当人类期望价值对齐时,若是让机器 (技术) 熟悉人类的价值观,则意味着价值观本身是明确的;若是让机器 (技术) 推断人类的价值观,则意味着机器 (技术) 的预测需要人类符合机器的意图。那么,上述两项的多次交互循环是否会出现人类价值观在技术化的进程中涌现诸如数字化身之类的技术化生命、比人类自身更懂人类的机器意志等现象呢?易言之,在人类为技术赋予人类价值观的进程中,是否会出现技术导引与规训人类价值观形成的情形呢?

类似 “在我们这个时代,每一种事物好像都包含有自己的反面。我们看到,机器具有减少人类劳动和使劳动更有成效的神奇力量,然而却引起了饥饿和过度的疲劳”(《马克思恩格斯全集》第12 卷,1962,第4 页) 一样,伴随技术发展所带来的神秘力量增强,机器与人类之间的微妙关系迫使人类审视技术的本质并寻求这种神奇性的破解,而人类与技术的边界厘清就是解开这种微妙关系的关键点。因此,为了避免神奇力量的反面,以人机 (技) 融合为出发点的价值对齐,既需要合乎道德的合作与信任,更需要有边界的合作与信任。

(二) 信任与信任的反面:价值对齐的有效性

信任作为委托者与受托者之间的一种合作性关系,其“处在全知与无知之间;全知意味着确定性,它不再需要信任。无知则无法建立信任。全知与无知之间的状态是产生信任的条件,信任则启动了生存所需要的行动和合作”。( 郑也夫,2015,第225 页) 因此,当信息的不充分与模糊性成为了信任产生的源头时,对信任的解构、关于反信任和不信任等信任反面的研究更值得关注,对信任反面的充分认知恰恰是建立信任的必要条件。

就技术研发而言,弗雷斯特 (Forrester) 前首席分析师约翰·金德维格 (John Kindervag) 于 2010 年提出零信任 (Zero Trust),信任以验证为基础,不验证不信任。( Moscaritolo A.,2011)以不信任为前提所展开的系统构建是提升系统安全性的一条重要途径。事实上,不信任是“信任的反面镜像”,(彼得·什托姆普卡,2005,第34 页) 怀疑 (mistrust) 是“一个暂时的信任建立或者信任丧失动态的中间阶段。怀疑既可能是信任破坏的前奏,也可能是不信任结束的预兆”。(彼得·什托姆普卡,2005,第34 页) 在价值对齐的研发中,对智能体的信任以及智能体之间的信任并非是默认的,恰恰是需要信任或者信任产生之处的治理来构建信任。

为了确保人工智能安全,对通过欺骗而获得奖励的行为监测与治理就是对合作性信任破坏的修复,红队测试则通过对危害的发现和识别来探寻并规避价值对齐的危险,进而提升系统的可信度。近年来所展开的“给AI 的100 瓶毒药”就是以安全和负责任为基准,以投毒与解毒两条路径进行大语言模型的价值观调整,进而提升大模型与人类价值观的对齐能力。(Guohai Xu et al., 2023) 类似未经破坏性测试的技术是不可靠的,未考虑信任反面测试的信任也是脆弱的。因此,价值对齐的有效性提升必须要将信任反面的消除予以充分考虑。

四、结语

关于价值对齐的探讨,说明人类有价值对齐的诉求但目前尚未实现,甚或人类尚未明晰价值对齐的基准与意义。之所以如此,主要原因有二:

一是源自人类一直有技术为人类服务且技术必须处在人类可控之中的梦想。这样一种梦想植根于人类中心主义。然而,技术的日趋自主性与智能化对人类中心主义所构成的挑战使得上述梦想备受质疑。如,当下关于数字生命、智能机器意识、数字资本主义等的一系列追问直接指向了人类作为类的本质何在;近年来所出现的将技术道德化,与其说是对人类道德未来发展路径的一种描绘,倒不如说是对技术反噬人类道德的一种沉思。因此,这一切促使人类既需要重新反思人之为人这一经典问题,更需要对技术的发展进行前瞻性的预判,确立价值对齐的基准,厘清价值对齐的边界。

二是价值对齐的意义究竟是什么?很明显,价值对齐的意义不应是技术政治学所揭示的“引入技术手段所产生的一系列转化最终导致了目的转化” (兰登·温纳,2014,第203 页) 的反向适应。当价值对齐力图寻求人类价值观与技术所体现的价值观一致之时,人的技术化与技术的人化将更加深入。仅仅作为工具意义上的技术已经不再可能,人类与人工智能联盟所形成的团队合作推进着人的本质与技术的本质在更为深层的意义上的交互,但这种交互不应是在合作式对齐进程中变成人类对技术的反向适应,走向技术系统对人类的操纵。

可以肯定的是,价值对齐的意义应是技术为人类带来福祉。因此,价值对齐虽然是在多方的合作中展开将人类价值观的技术化,但其并非仅仅是将技术道德化,也不仅仅是目标的技术化转换,更不能以非道德的方式进行“对齐”,并且应在技术可信可控的情境中展开,因为脱离此情境的交互必将会给人类带来毁灭性的灾难。基于此,必须以基于道德的信任校准价值对齐,将人类作为信任链构建的出发点和落脚点,才能规避价值对齐的陷阱,确保人工智能的安全。

【本文首发于《浙江社会科学》2024年第6期】

还没有评论,来说两句吧...